AI-forskare hjälper robotar att se under vatten – tekniken kan rädda liv

AI-forskarna Kavyaa Somasundaram och Martin Längkvist på Örebro universitet och mjukvaruutvecklare Martin Karlsson på Piktiv AB samlar in data tillsammans med Saab och Nerikes Brandkår. Här testar de en undervattensrobot för att lära sig mer om hur sonarbilderna ser ut och ska tolkas.

Genom att kombinera data från kamera och sonar har AI-forskare på Örebro universitet gett undervattensrobotar bättre syn. Det hjälper operatörer av Saabs farkoster att genomföra sina uppdrag mer effektivt – och kan för Nerikes Brandkår till och med vara skillnaden mellan liv och död.

– Det här förbättrar våra odds att kunna rädda liv, säger Mats Hallgren på Nerikes Brandkår.

Undervattensfarkoster kan användas av många aktörer i en rad olika syften, som till exempel inspektion av infrastruktur såsom oljerörledningar eller att eftersöka människor som försvunnit under vatten.

Ett problem för undervattensrobotar är att se i grumligt och mörkt vatten. För att lösa det problemet lanserade Örebro universitet, genom det regionala utvecklingsprojektet AI.ALL, pilotprojektet Saight tillsammans med Saab, Nerikes Brandkår och mjukvaruutvecklaren Piktiv AB.

”Viktigt att vara med i innovativ utveckling”

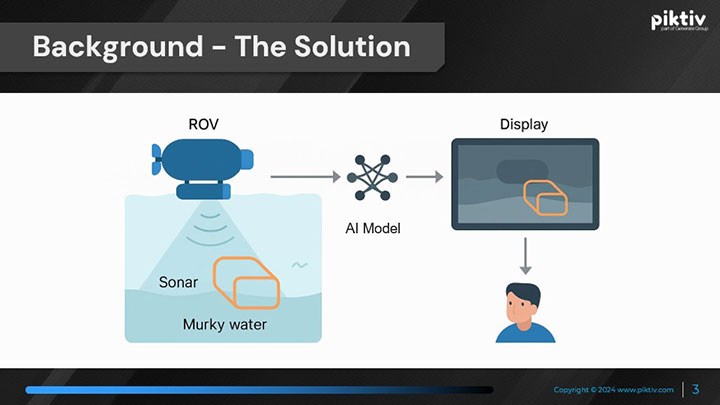

– Vi tillverkar undervattensfarkoster som ofta är fjärrstyrda av en operatör. Vi vill försöka underlätta för operatören när det är grumligt vatten. I sådana miljöer ser man väldigt dåligt i kameran och då får operatören jobba länge för att kunna lösa sina uppgifter. Så tanken var att med hjälp av AI och ”augmentet reality” kombinera en sonarsensor som ser igenom grumligt vatten med den vanliga kameran, säger Gert Johansson på Saab.

– För oss på Nerikes Brandkår är det viktigt att vara med i innovativ utveckling. Det här kommer i framtiden att göra vår vardag lättare. Vi har haft stora problem med att hitta personer som försvinner under ytan. Det är svårt att lära sig sonar- och ekolodsteknik. Här implementeras AI som hjälper oss som operatörer att tolka bilderna. Det gör att vi i ett tidigare skede kan lokalisera en person och förkorta tiden som den är under ytan, säger Mats Hallgren på Nerikes Brandkår.

Mjukvaruutvecklaren Piktiv AB:s roll i projektet har varit att bygga en simulation, ungefär som ett datorspel, som projicerar bilder från sonar och ekolod och där olika scenarion kan spelas upp i träningssyfte.

– Den största utmaningen för oss har varit att jobba med AI-modeller och försöka få dem att göra bra ifrån sig. Man behöver experimentera mycket. Det har varit enormt roligt att arbeta tillsammans med Örebro universitet, Saab och Nerikes Brandkår. Man märker verkligen de olika expertområdena i det här projektet, säger Martin Karlsson på Piktiv.

Borrade hål i isen och provkörde undervattensroboten

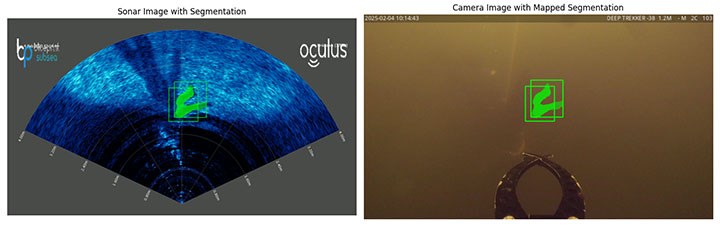

Ansvarig forskare i Saight-projektet har varit Kavyaa Somasundaram, industridoktorand Saab vid Örebro universitet. Hon har utvecklat en specialanpassad AI-algoritm som analyserar data från kameran och sonaren på undervattensroboten och predikterar var och vilka objekt som finns i miljön runt roboten, som annars hade varit svåra att upptäcka med det mänskliga ögat.

– En utmaning var att tolka sonardatan. Den är väldigt stökig och innehåller mycket brus. Ibland har man ingen aning om vad man tittar på. Vi genomförde en kunskapsöverföring tillsammans med Saab och personal från räddningstjänsten för att förstå vad vi annoterade i datan och vad vi ville att modellen skulle lära sig, säger Kavyaa Somasundaram och fortsätter:

– Man måste samla in mycket data och vara på plats för att förstå vad man faktiskt ser. En iskall dag borrade vi ett hål i isen på en sjö och satte ned roboten för att kunna se på riktigt hur till exempel en skugga ser ut på sonarbilden. Det var en viktig lärdom för mig.

– Med hjälp av denna kunskapsöverföring, expertis inom datavetenskap, samt nyinsamlade data kunde Kavyaa Somasundaram och Örebro universitet bidra med det akademiska arbetet med att utveckla en ny teknisk metod som inte tidigare finns publicerad eller tillgänglig att använda, säger Martin Längkvist, teknisk projektledare för Saight och universitetslektor i datavetenskap vid Örebro universitet, och fortsätter:

– En stor fördel med metoden är att den är lätt att använda. Man behöver inte vara expert på att tolka sonardata eller ha förkunskap om hur AI-teknik fungerar. Metoden fungerar både i klart och grumligt vatten utan att användaren behöver göra några manuella inställningar om sikten skulle försämras under arbetet med undervattensroboten, vilket är ett ofta förekommande scenario. I klart vatten förlitar sig algoritmen automatiskt mer på kameran, medan den i grumligt vatten använder datan från sonaren mer i analysen.

Det finns idéer på hur metoden skulle kunna fortsätta att utvecklas, förklarar Martin Längkvist.

– Framtida arbete är att träna AI-algoritmen på både mer insamlad riktig data och simulerad data. Utmaningen där är att antingen försöka få den simulerade datan att se ut som riktig data eller att vidareutveckla AI-modellen så att den inte kan urskilja på riktiga eller simulerade data, säger Martin Längkvist.

”Förbättrar oddsen att rädda liv”

Kavyaa Somasundaram påpekar att resultaten från projekten kan komma till stor nytta inom många olika områden i samhället.

– Jag tror att det finns en enorm potential för den här lösningen. Vi har nu visat hur dessa algoritmer kan användas i undervattensmiljöer. Men om man tänker efter kan modellerna användas inom många andra områden – som autonoma fordon eller i gruvor, där man har liknande problem med till exempel dimmiga miljöer där sikten är låg. Om vi kan anpassa modellerna till olika tillämpningsområden tror jag att vi kan få mycket goda resultat, säger Kavyaa Somasundaram.

Mats Hallgren på Nerikes Brandkår håller med. Han tror till och med att AI-algoritmen kan hjälpa till att rädda liv.

– När vi jobbar är tiden alltid en aspekt. Om det går fortare att hitta och få upp en person ur vattnet, så förbättrar vi oddsen att rädda liv. Och med den här lösningen går det snabbare.

Saight är ett samarbete mellan Örebro universitet, Saab, Nerikes Brandkår och Piktiv AB. Projektet, som är en del av AI, Robotics and Cybersecurity Center (ARC), stöttas av det regionala utvecklingsprojektet AI.ALL och medfinansierats av Region Örebro län och Europiska unionen.

Text: Jesper Eriksson

Foto: Linda Harradine, Jesper Eriksson och privat